- Интеллектуальные алгоритмы для малых данных: как добиться максимальной эффективности?

- Почему важно учитывать количество данных?

- Обзор лучших алгоритмов для задачи с малым N

- k-ближайших соседей (k-NN)

- Плюсы и минусы k-NN

- Наивный байесовский классификатор

- Когда использовать наивный байес

- Легкие регрессионные модели

- Плюсы и минусы регрессионных моделей

- Дополнительные подходы для работы с малыми N

- Перекрестная проверка (кросс-валидация)

- Бутстрэппинг

- Инженерия признаков

- Практические рекомендации по применению алгоритмов

Интеллектуальные алгоритмы для малых данных: как добиться максимальной эффективности?

Когда мы сталкиваемся с задачами обработки данных, зачастую сталкиваемся с ситуациями, когда объём информации не позволяет использовать классические модели машинного обучения или требует особого подхода. В таких случаях особенно важны оптимальные алгоритмы для малых N, которые позволяют добиться высокой точности и надежности при ограниченных данных. В этой статье мы подробно рассмотрим, какие алгоритмы лучше всего подходят для таких условий, как их правильно применять и какие особенности нужно учитывать для достижения максимальной эффективности.

Почему важно учитывать количество данных?

В современной аналитике и машинном обучении объём данных зачастую считается ключевым фактором успеха. Чем больше данных — тем легче выявить закономерности, построить точную модель и сделать надежные прогнозы. Однако в реальной жизни далеко не всегда есть возможность собрать большие объёмы информации. Иногда у нас есть лишь несколько образцов, и именно в таких сценариях нужно искать решения, которые эффективно работают при малых N.

Особенности работы с малыми данными:

- Высокая вероятность переобучения, модель слишком точно подгоняется под малый набор данных и не умеет обобщать.

- Недостаток статистической мощности — сложно выявить значимые закономерности.

- Чувствительность к выбросам — в маленьком наборе даже один выброс способен существенно исказить результаты.

Исходя из этого, для небольших N нужно выбирать особенные алгоритмы, способные показывать хорошие результаты без необходимости большого объема данных.

Обзор лучших алгоритмов для задачи с малым N

Наиболее эффективными в условиях ограничения по количеству данных считаются следующие методы:

- k-ближайших соседей (k-NN)

- Наивный байесовский классификатор

- Легкие регрессионные модели

- Методы на базе перекрестной проверки и бутстрэппинга

- Классификация с использованием деревьев решений

Рассмотрим каждый из них более подробно.

k-ближайших соседей (k-NN)

Это один из самых простых и одновременно универсальных алгоритмов. Он не требует обучения в классическом понимании, а основан на измерении расстояний между точками в пространстве признаков. При малом наборе данных k-NN показывает отличные результаты, если правильно настроить параметр k.

Особенности использования:

- Выбор числа k — важно подобрать оптимальное значение методом кросс-валидации.

- Обратить внимание на выбор метрики расстояния (евклидова, манхэттена и т.д.).

- Применять масштабирование признаков, чтобы избежать доминирования одних переменных над другими.

Плюсы и минусы k-NN

| Плюсы | Минусы |

|---|---|

| Легкость реализации и понимания | Медленная работа при большом количестве признаков |

| Хорошо работает с небольшими наборами данных | Чувствителен к выбору гиперпараметра k и метрики |

Наивный байесовский классификатор

Данный алгоритм основывается на теореме Байеса и предполагает независимость признаков. Несмотря на очевидное упрощение — в большинстве случаев он показывает высокую точность на малых наборах данных.

Преимущества:

- Легко обучается и работает быстро

- Может использоваться для категориальных и числовых данных

- Хорошо справляется с шумами и выбросами

Недостатки:

- Предположение о независимости признаков не всегда реально

- Работает хуже на сложных данных с сильными зависимостями

Когда использовать наивный байес

| Плюсы | Минусы |

|---|---|

| Быстрая и простая реализация | Предположение о независимости редко полностью оправдывается |

| Высокая точность на небольших данных | Могут возникать ошибки при сильной зависимосте признаков |

Легкие регрессионные модели

Линейные и логистические регрессии — это классические модели, которые при небольшой сложности данных показывают отличные результаты. Они легко интерпретируемы и требуют небольшого объема для обучения.

Особенности применения:

- Важно правильно подготовить данные и устранить мультиколлинеарность.

- Регуляризация поможет избежать переобучения.

Плюсы и минусы регрессионных моделей

| Плюсы | Минусы |

|---|---|

| Простота и интерпретируемость | Могут плохо справляться с нелинейными зависимостями |

| Малое количество данных, преимущество | Требуются аккуратные настройки регуляризации |

Дополнительные подходы для работы с малыми N

Помимо выбора алгоритма, есть ещё методы и техники, которые позволяют повысить эффективность работы с ограниченными данными.

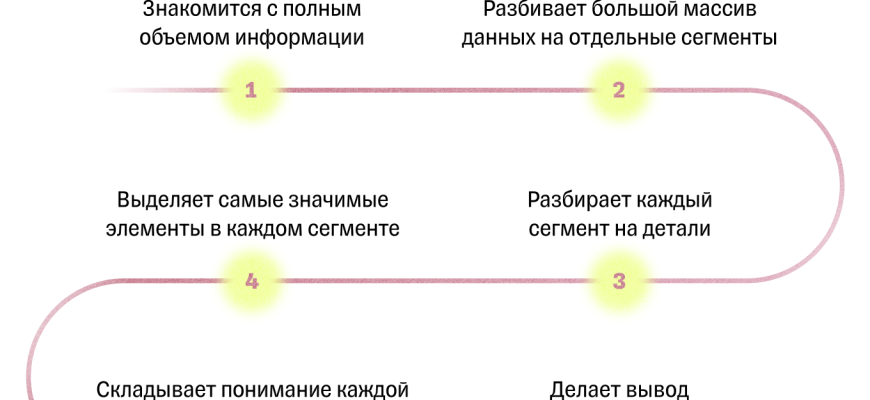

Перекрестная проверка (кросс-валидация)

Обязательно использовать методы валидации для получения более точной оценки модели. Особенно важна k-fold кросс-валидация, которая позволяет проверить стабильность модели при различных разбиениях данных.

Бутстрэппинг

Статистический метод, который помогает оценить надёжность модели, создавая множество случайных подвыборок с повторениями и анализируя результаты. Особенно полезен при малых N для оценки вариации модели и избежания переобучения.

Инженерия признаков

Создание дополнительных признаков или их преобразование помогает повысить информативность модели при небольшом объёме данных. Важно избегать чрезмерной фиксации на сложных признаках, чтобы не переобучить модель.

Практические рекомендации по применению алгоритмов

Чтобы добиться успеха в задачах с малым N, следуйте этим рекомендациям:

- Проводите тщательную предобработку данных — очистку, масштабирование, устранение выбросов.

- Верно выбирайте алгоритм, тестируйте несколько методов и сравнивайте результаты.

- Используйте кросс-валидацию — только так можно объективно оценить эффективность модели.

- Настраивайте гиперпараметры — особенно важно для k-NN и моделей регрессии.

- Создавайте дополнительные признаки, расширяйте информационное поле, если это возможно.

Вопрос: Какие алгоритмы лучше всего подходят при очень ограниченных данных, менее 20 образцов?

Ответ: В условиях крайне малых данных, таких как менее 20 образцов, наиболее подходящими являются простые и интерпретируемые методы — k-ближайших соседей, наивный байесовский классификатор и традиционные регрессионные модели. Эти алгоритмы требуют минимальной настройки, быстро обучаются, и при правильной подготовке данных дают надежные результаты без чрезмерного риска переобучения. Также важно использовать методы кросс-валидации и бутстрэппинг для оценки стабильности модели, чтобы избежать ложных выводов и повысить доверие к полученным результатам.

Подробнее

| Общие рекомендации | Используйте простые модели, избегайте сложных алгоритмов без достаточного объема данных |

| Методы оценки | Кросс-валидация, бутстрэппинг — обязательны для оценки стабильности |

| Формирование признаков | Создавайте дополнительные признаки и используйте их для улучшения модели |

| Особенности данных | Обращайте внимание на выбросы и шумы, они могут сильно исказить результаты |

| Поддержка практики | Постоянно тестируйте разные гиперпараметры и подходы |